Human Entities 2017: a cultura na era da inteligência artificial

Um ciclo de conversas organizado pelo CADA em parceria com a Trienal de Arquitectura de Lisboa

Outubro – novembro 2017

Entrada livre, mediante registo

[English below]

Sinopse

À medida que carros autónomos surgem nas estradas públicas, exércitos de bots se envolvem em amargas guerras culturais, e sistemas de deep-learning ganham aos melhores jogadores humanos no poker e no Go, muita da exagerada propaganda em torno das máquinas inteligentes começa a soar verdadeira. A inteligência artificial está a entrar na vida quotidiana a um ritmo intenso e a velocidade do seu avanço surpreende até os seus criadores.

Mais do que com qualquer anterior tecnologia, a implantação de sistemas autónomos em complexos ambientes de dados está a desvanecer as fronteiras entre pessoas e máquinas. Artefactos tecnológicos já não são entendidos como meras ferramentas mas antes como agentes igualmente activos nas nossas relações sociais e parte integrante do substrato que está a redesenhar muitas formas de cultura.

Bem gerida, a inteligência artificial pode ter um papel decisivo para o bem social. Mas é tudo menos neutra. As tecnologias de automatização correspondem a modelos do mundo que representam os valores e as assunções dos seus criadores – uma mão cheia de corporações com poderosos interesses económicos.

Como podemos garantir que estes novos modelos do mundo são reinseridos no discurso cultural e que permitem maior diversidade? Como podemos compreender as semelhanças e diferenças entre a inteligência humana e a das máquinas?

CADA – Sofia Oliveira/Jared Hawkey

Human Entities é um ciclo de conversas focado na mudança tecnológica e nos seus impactos – nas formas como a cultura e a tecnologia se influenciam mutuamente.

Quarta, 4 outubro 2017, 18.30-20.30

Porque importam as histórias: narrativas sobre inteligência artificial, risco existencial, e ciência

Adrian Currie (NZ/UK)

The Centre for the Study of Existential Risk, University of Cambridge, UK

Quero falar sobre a forma como as histórias – narrativas – sobre tecnologias emergentes, como a inteligência artificial, afectam o modo como estas são recebidas fora da ciência, e como são desenvolvidas dentro da ciência.

O nosso poder tecnológico está a aumentar a um ritmo tal que a nossa capacidade para o controlar e compreender tem dificuldades em acompanhar. Dado o poder transformativo que as tecnologias emergentes provavelmente terão para a sociedade humana, considerar os possíveis futuros que estas nos trarão, é crucial.

A minha abordagem a esta reflexão é através da discussão do risco existencial: riscos que, a acontecerem, são uma ameaça à nossa existência como espécie, ou a aspectos cruciais da civilização humana. Falarei de porque está a ciência, da forma como se organiza actualmente, mal equipada para lidar com riscos existenciais.

Em síntese, a ciência contém atributos que a tornam produtiva mas conservadora, e este conservadorismo prejudica a nossa capacidade de pensar da forma criativa e especulativa que o risco existencial requer. A partir desta discussão, falarei da importância das narrativas na nossa compreensão do risco existencial e das tecnologias emergentes, em particular a inteligência artificial. Se é verdade que as histórias que contamos sobre a tecnologia moldam o seu desenvolvimento, então se estas são escassas, ou pobres, podem deformar o progresso tecnológico e produzir problemáticos – ou desastrosos – resultados.

Adrian Currie

Adrian está particularmente interessado na forma como os cientistas produzem conhecimento em circunstâncias complicadas: onde a evidência no terreno é ténue, os objectos são complexos e obstinados, e a nossa compreensão é limitada. Enfatiza as estratégias oportunísticas, pluralistas e especulativas que os cientistas adoptam para ultrapassar esses desafios. Publicou amplamente em tópicos como o método nas ‘ciências históricas’ (paleontologia, arqueologia e geologia), o método comparativo em biologia, a natureza e ciência da música, questões éticas e científicas na geoengenharia e a importância do storytelling na ciência. Terminou o seu PhD na Universidade Nacional Australiana em Camberra, leccionou e trabalhou na Universidade de Victoria em Wellington, Universidade de Sydney, Universidade de Calgary, Universidade de Bucareste e na Universidade de Cambridge onde trabalha actualmente no Centro para o Estudo do Risco Existencial. No centro, investiga de que forma a estrutura de incentivos que orienta a ciência, a torna frequentemente conservadora, e potencialmente inadequada para os desafios que poderosas tecnologias representam.

Links:

CSER, http://cser.org

https://sites.google.com/

http://

A conversa com Adrian Currie será seguida de uma sessão de Q&A moderada por Joana Lobo Antunes, Coordenadora do Gabinete de Comunicação do Instituto de Tecnologia Química e Biológica, Universidade Nova de Lisboa.

Local: Trienal de Arquitectura de Lisboa, Campo de Santa Clara, 142-145, 1100-474, Lisboa

Data: Quarta, 4 outubro, 2017, 18.30-20.30

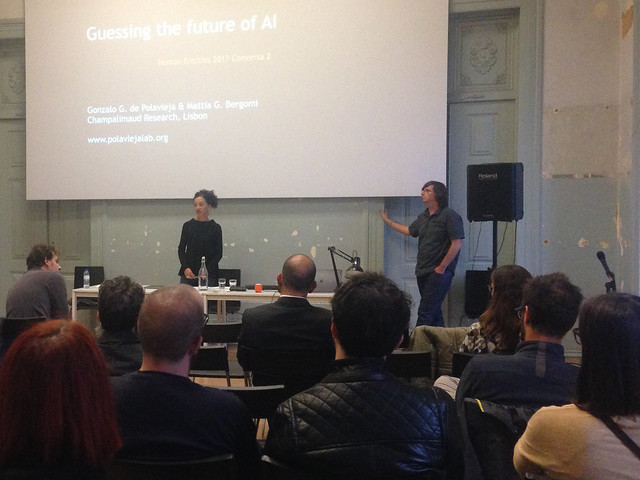

Quarta, 18 outubro 2017, 18.30-20.30

Imaginando o impacto da inteligência artificial

Gonzalo de Polavieja (ES/PT)

Champalimaud Centre for the Unknown, Neuroscience Programme, Lisboa

Começarei com algumas demos do que pode fazer a inteligência artificial (IA) hoje. Também tentarei transmitir o que não consegue fazer de momento. Depois tentarei adivinhar que tipo de coisas as tecnologias semelhantes conseguirão fazer num novo futuro. Embora tenha uma atitude bastante positiva em relação à IA, é claro que esta tecnologia será muito poderosa e com capacidade de transformar drasticamente as nossas sociedades. Listarei alguns dos riscos e benefícios da tecnologia antes de abrir a discussão.

Gonzalo de Polavieja

Trabalho na Fundação Champalimaud tentando compreender o comportamento colectivo nos animais, incluindo humanos. Usamos IA como parte da nossa abordagem e também investigamos técnicas alternativas às utilizadas correntemente. Anteriormente, trabalhei no Instituto Cajal em Madrid e no Departamento de Física Teórica da Universidade Autónoma em Madrid. A minha vida como investigador começou com um PhD em Ciências Físicas na Universidade de Oxford, UK.

Links:

http://www.polaviejalab.org

http://neuro.fchampalimaud.org/en/research/investigators/research-groups/group/de Polavieja

A apresentação do Gonzalo conta com a participacão de Mattia Bergomi

Local: Trienal de Arquitectura de Lisboa, Campo de Santa Clara, 142-145, 1100-474, Lisboa

Data: Quarta, 18 outubro 2017, 18.30-20.30

Quarta, 8 novembro 2017, 18.30-20.30

Quando é que a inovação não é realmente inovadora?

Izabella Kaminska (UK)

FT Alphaville, Financial Times, Londres

Existe uma presunção na tecnolandia de que toda a inovação é boa, e que mais informação e data só podem produzir resultados positivos. Mas, e se a inovação puder ser boa e má? Por exemplo, os criminosos são altamente inovadores, mas acrescentam realmente algum valor? Da mesma forma, informação pode ser precisa ou enganosa. A estatística pode ser grandemente mal usada para confirmar preconceitos ao invés de estabelecer conclusões neutras.

E enquanto a nossa mentalidade cultural se aproxima cada vez mais da aceitação de grupos diversos, estão a ser introduzidos algoritmos e redes neurais que não possuem este tipo de empatia e acabam por discriminar desapaixonadamente. Em corporações de todo o mundo, num claro exemplo do paradoxo de Jevons em acção, administradores e pessoal crucial estão a ser dispensados ou reduzidos apenas para serem substituídos por grupos de consultores de TIC ainda mais caros (e muitas vezes de maior dimensão). Na maioria dos casos com muito pouco impacto nos resultados. A ideia que Robert Solow avançou nos anos 90, de que podemos ver a era do computador em todo o lado excepto nas estatísticas de produtividade, ainda não se dissipou como resultado.

Numa era onde a Google pode despedir um trabalhador por este acreditar que as mulheres podem ser naturalmente inclinadas para várias profissões, mas o seu próprio algoritmo manifesta constantemente imensos pressupostos sobre as tendências e inclinações das mulheres, enquanto ao mesmo tempo estimula a criação de vantagens que derivam de conhecimentos prévios sobre os consumidores na internet, temos que nos interrogar sobre que interesses está Silicon Valley realmente a servir? A tecnologia que não capacita as massas dificilmente é libertadora ou progressiva.

Nesta apresentação, Izabella Kaminska aborda algumas das maiores falácias veiculadas pela comunidade tecnológica e estimula a audiência a questionar a lógica subjacente a alguma da retórica que é ‘impingida’ às massas sobre os sistemas tecnológicos.

Izabella Kaminska

Izabella Kaminska é escritora, blogger e colunista para o Financial Times onde escreve para o premiado blog FT Alphaville e para as suas secções de opinião. Escreve regularmente sobre tecnologia, media e tendências de mercado, assim como economia, banca e finança. Nos últimos anos desviou a sua atenção para a ascensão da fintech, da economia da partilha e da cryptocurrency. Antes de se juntar ao FT, Izabella foi produtora para a CNBC e repórter para a Reuters. Iniciou a sua carreira a trabalhar para empresas de língua inglesa na antiga União Soviética, enquanto desenvolveu conhecimento especializado sobre a indústria petroquímica. Também trabalhou como editora associada da revista interna da BP.

Links:

https://ftalphaville.ft.com/author/Izabella Kaminska

@izakaminska

A conversa com Izabella será seguida de uma Q&A moderada por Sandro Mendonça (Professor, ISCTE Business School e colunista do jornal Expresso)

Local: Trienal de Arquitectura de Lisboa, Campo de Santa Clara, 142-145, 1100-474, Lisboa

Data: Quarta, 8 novembro, 2017, 18.30 – 20.30

Quarta, 22 novembro 2017, 18.30-20.30

Podem os agentes artificiais criar arte?

Para um pensamento sobre as performances humano/não-humano

Mark Coeckelbergh (BE/AT)

Universidade de Viena

Muitas das atuais visões sobre o futuro da inteligência artificial focam-se ora em cenários distópicos e risco existencial, ora num acrítico sonho de novas formas de melhoria dos humanos, como por exemplo em algumas versões do trans-humanismo. Contudo, estas abordagens não nos ajudam a lidar com os desafios que os agentes artificiais levantam num futuro próximo. Tendem também a excluir a reflexão sobre a dimensão social e cultural do tema, incluindo uma mais construtiva e criativa reflexão sobre as formas como humanos e agentes artificiais podem colaborar e co-criar.

Nesta apresentação, Mark Coeckelbergh discute se os agentes artificiais podem criar arte e propõe uma abordagem à questão que é cultural, social e com um toque moderadamente pós-humanista.

Infuenciado por Wittgenstein, Pickering, e Latour, argumenta que artefactos criados e utilizados por humanos e agentes artificiais ganham o seu significado a partir do todo sociocultural onde se inserem pois co-constituem estas interacções e formas de vida, que a nossa forma de vida sempre envolveu humanos e não-humanos, e que a questão da criatividade de agentes artificiais deve ser reformulada como a questão do sentido cultural e das possibilidades artísticas das performances humanos/não-humanos – ainda que quando comparado com agentes artificiais os humanos continuem a ser os únicos performers e espectadores num sentido estrito devido à sua subjectividade e corporalização.

Mark Coeckelbergh

Mark Coeckelbergh é Professor de Filosofia dos Media e Tecnologia no Departamento de Filosofia da Universidade de Viena, Áustria e Professor part-time de Tecnologia e Responsabilidade Social no Centre for Computing and Social Responsibility, Universidade De Montfort, Reino Unido. É Presidente da Society for Philosophy and Technology. Anteriormente leccionou na Universidade de Twente e foi Director-Geral do 3TU Centre for Ethics and Technology. Os seus livros incluem Using Words and Things (Routledge 2017), New Romantic Cyborgs (MIT 2017), Money Machines (Ashgate 2015), Environmental Skill (Routledge 2015), Human Being @ Risk (Springer 2013), Growing Moral Relations (Palgrave Macmillan 2012), e numerosos artigos na área da filosofia da tecnologia em particular na filosofia da robótica e ICT, linguagem e tecnologia, e criatividade das máquinas. Explora activamente questões relacionadas com a tecnologia através de colaborações com artistas e curadores.

Links:

https://coeckelbergh.wordpress.com

@MCoeckelbergh

Local: Trienal de Arquitectura de Lisboa, Campo de Santa Clara, 142-145, 1100-474, Lisboa

Data: Quarta, 22 novembro, 2017, 18.30–20.30

ENGLISH

Human Entities 2017: culture in the age of artificial intelligence

Public talks, October – November 2017

Organised by CADA in partnership with the Lisbon Architecture Triennale

Free admission; registration required

Overview

As self-driving cars appear on public roads, armies of bots engage in bitter cultural wars, and deep learning-based systems beat the best human players at poker and Go, much of the hype about smart machines is starting to ring true. Artificial intelligence is entering everyday life at a blistering pace, and the speed of its advance is even surprising its creators.

More than any previous technology, the deployment of autonomous systems in complex data environments is blurring the boundaries between people and machines. Technological artefacts are no longer merely seen as tools but rather equally active agents in our social relations and part of the underlying substrate that is rewiring many forms of culture.

Managed well, artificial intelligence could be a major contributor to social good. But it is anything but neutral. Automation technologies correspond to models of the world which represent the values and assumptions of its creators – the handful of corporations with powerful vested interests.

How can we ensure these new world models are brought back into cultural discourse and that they allow for greater diversity? How can we understand the similarities and differences between human intelligence and that of machines?

CADA – Sofia Oliveira/Jared Hawkey

Human Entities is a series of talks focused on technological change and its impacts – the ways culture and technology shape and influence each other.

Wednesday 4 October 2017, 18.30-20.30

Why stories matter: AI narratives, existential risk, and science

Adrian Currie (NZ/UK)

The Centre for the Study of Existential Risk, University of Cambridge, UK

I want to talk about how stories—narratives—about emerging technologies like artificial intelligence matter to both how they are received outside science, and are developed within it.

Our technological power is increasing, often leaving our ability to control and understand it struggling to keep up. Given how transformative emerging technologies are likely to be for human society, considering the possible futures they might take us down are crucial.

My way into this discussion is through existential risk: risks which, if actualized, pose a threat to our existence as a species, or to crucial aspects of human civilization. I will talk about why science, as currently organized, is ill-suited for tackling existential risks.

In brief, science has features which make it productive but conservative, and this conservatism undermines our capacity to think in the creative, speculative ways that existential risks demand. From this discussion, I’ll turn to the importance of narratives in our understanding of existential risk and emerging technologies, artificial intelligence in particular. If it is right that the stories we tell about technology shape its development, then if our stories are too few, or too impoverished, that could warp technological progress and have problematic—or disastrous—results.

Adrian Currie

Adrian is primarily interested in how scientists generate knowledge in tricky circumstances: where evidence is thin on the ground, targets are complex and obstinate, and our understanding is limited. He emphasizes the opportunistic, pluralistic and speculative strategies scientists adopt to overcome such challenges. He has published widely on topics from the method of the ‘historical sciences’ (paleontology, archaeology and geology), the comparative method in biology, the nature and science of music, ethical and scientific issues concerning geoengineering, and the importance of storytelling in science. He completed his PhD at the Australian National University in Canberra and has taught and worked at the University of Victoria in Wellington, the University of Sydney, the University of Calgary, the University of Bucharest, and in Cambridge, where he currently works for the Centre for the Study of Existential Risk. At the centre, he is investigating how the incentive structures which drive science often make it conservative, and potentially inadequate for the challenges powerful emerging technologies pose.

Links:

CSER, http://cser.org

https://sites.google.com/site/adrianmitchellcurrie

http://www.extinctblog.org

Adrian’s talk will be followed by a Q&A session moderated by Joana Lobo Antunes, Head of Science Communication Office, Instituto de Tecnologia Química e Biológica, Universidade Nova de Lisboa.

Venue: Lisbon Architecture Triennale, Campo Santa Clara 142-145, 1100-474 Lisbon, Portugal

Date: Wednesday 4 October 2017, 18.30-20.30

Wednesday 18 October, 18.30-20.30

Guessing the impact of artificial intelligence

Gonzalo de Polavieja (ES/PT)

Champalimaud Centre for the Unknown, Neuroscience Programme, Lisbon

I will start with a few demos on what AI can do today. I will also try to convey what they cannot do at the moment. Then I will try to guess what kind of things similar technologies will be able to do in the new future. Although I have quite a positive attitude towards AI, it is clear that this technology will be very powerful and could change our societies dramatically. I will delineate some of the risks/benefits to quickly open a discussion.

Gonzalo de Polavieja

I work at the Champalimaud Foundation trying to understand collective behaviour in animals, including humans. We use AI as part of our approach and we are also investigating alternative techniques to those used today. Before, I worked at the Cajal Institute in Madrid and at the Theoretical Physics Department at Universidad Autonoma also in Madrid. My life as a researcher started with a PhD in Physical Sciences at Oxford University in the UK.

Links:

http://www.polaviejalab.org

http://neuro.fchampalimaud.org/en/research/investigators/research-groups/group/de Polavieja

Gonzalo’s talk will include a discussion with Mattia Bergomi

Venue: Lisbon Architecture Triennale, Campo Santa Clara 142-145, 1100-474 Lisbon, Portugal

Date: Wednesday 18 October 2017, 18.30-20.30

Wednesday 8 November, 18.30-20.30

When is innovation not really innovation?

Izabella Kaminska (UK)

FT Alphaville, Financial Times, London

There’s a presumption in technologyland that all innovation is good, and that more information and more data can only lead to positive outcomes. But what if innovation can be both good and bad? For example, criminals are highly innovative, but are they really adding value? Information too can be both accurate or misleading. Statistics can be grossly misused to confirm biases rather than set out neutral findings.

And whereas our cultural mindset is moving towards greater acceptance of diverse groups, algorithms and neural networks are being introduced which lack this sort of empathy entirely and end up discriminating in-passionately. At corporations around the world, in a clear example of Jevons paradox in action, administrators and core staff are being laid off or downsized only to be replaced with even more expensive (and often larger) cohorts of IT consultants in the long run. Most of the time there’s very little impact on the bottom line.

The proposition Robert Solow’s put forward in the 90s that we can see the computer age everywhere but in the productivity statistics is simply not dissipating as a result.

In an era when Google can fire an employee for believing that women may be naturally inclined towards different professions, yet its own algorithms make huge presumptions about the tendencies and inclinations of women all the time, while encouraging gaming and front-running of consumers on the internet, we have to ask just whose interests is Silicon Valley really serving? Technology that fails to empower the masses is hardly liberating or progressive.

In this presentation, Izabella Kaminska will address some of the major technological fallacies being propagated by the tech community and ask the audience to question the logic behind some of the rhetoric being force fed to the masses with regards to technological systems.

Izabella Kaminska

Izabella Kaminska is a writer, blogger and columnist for the Financial Times‘s award-winning FT Alphaville blog as well as for its opinion

pages. She regularly reports about technology, media and market trends, as well as economics, banking and finance. In the last few

years she’s turned her attention to the rise of fintech, the sharing economy and cryptocurrency. Before joining the FT, Izabella was a producer for CNBC and a reporter for Reuters. She started her career working for English-language business titles in the former Soviet Union, while developing specialist knowledge about the petrochemical industry. She has also worked as an associate editor of BP’s internal magazine.

Links:

https://ftalphaville.ft.com/author/Izabella Kaminska

@izakaminska

Izabella’s talk will be followed by a Q&A session moderated by Sandro Mendonça (Professor, ISCTE Business School and columnist at Expresso newspaper)

Venue: Lisbon Architecture Triennale, Campo Santa Clara 142-145, 1100-474 Lisbon, Portugal

Date: Wednesday 8 Nov 2017, 18.30-20.30

Wednesday 22 November 2017, 18.30-20.30

Can artificial agents create art? Towards thinking about human/non-human performances

Mark Coeckelbergh (BE/AT)

University of Vienna

Many current visions about the future of artificial intelligence either focus on dystopian scenarios and existential risk, or uncritically dream of new ways of human enhancement, as for instance some versions of transhumanism. These ways of approaching the topic are unhelpful, however, in dealing with the challenges of artificial agents in the near future. They also tend to exclude reflection on the social and cultural dimension of the issue, including the more constructive and creative possibilities of how humans and artificial agents may collaborate and co-create.

In this talk, Mark Coeckelbergh discusses the question whether artificial agents can create art and proposes to give a cultural, social, and moderately posthumanist twist to the question.

Influenced by Wittgenstein, Pickering, and Latour, he argues that artefacts created and used by both humans and artificial agents get their meaning from the larger social-cultural wholes they are embedded in as much as they co-constitute these games and form of life, that our form of life has always been involving humans and non-humans, and that the question regarding the creativity of artificial agents should be reformulated as the question regarding the cultural meaning and artistic possibilities of human/non-human performances – even if compared to artificial agents humans remain the only performers and spectators in a strong sense due to their social subjectivity and embodiment.

Mark Coeckelbergh

Mark Coeckelbergh is Professor of Philosophy of Media and Technology at the Department of Philosophy, University of Vienna, Austria and part-time Professor of Technology and Social Responsibility at the Centre for Computing and Social Responsibility, De Montfort University, UK. Currently he is the President of the Society for Philosophy and Technology. Previously he was teaching at the University of Twente and was Managing Director of the 3TU Centre for Ethics and Technology. His publications include Using Words and Things (Routledge 2017), New Romantic Cyborgs (MIT 2017), Money Machines (Ashgate 2015), Environmental Skill (Routledge 2015), Human Being @ Risk (Springer 2013), Growing Moral Relations (Palgrave Macmillan 2012), and numerous articles in the area of philosophy of technology, in particular philosophy of robotics and ICT, language and technology, and machine creativity. He also actively explores questions concerning technology through collaborations with artists and curators.

Links:

https://coeckelbergh.wordpress.com

@MCoeckelbergh

Venue: Lisbon Architecture Triennale, Campo Santa Clara 142-145, 1100-474 Lisbon, Portugal

Date: Wednesday 8 November 2017, 18.30-20.30

Organização CADA em parceria com a Trienal de Arquitectura de Lisboa

Organised by CADA in partnership with the Lisbon Architecture Triennale

Estrutura financiada por: | Funded by:

Apoio: | Supported by:

Design: Marco Balesteros (Letra)